深入探讨Netty的架构和设计原理,包括其基于NIO(非阻塞IO)和异步编程模型的优势,如何处理大量并发连接以及实现低延迟和高吞吐量。

chou403

/ Middleware

/ c:

/ u:

/ 9 min read

一学一个不吱声

以下是对 Netty 及相关技术概念(如 Selector,BIO,NIO,Epoll,零拷贝机制,DirectByteBuffer,I/O 多路复用等)的深入解读,逐一展开分析:

1. Netty

Netty 是一个高性能,异步事件驱动的网络框架,基于 Java NIO 提供抽象封装。它的设计旨在解决传统 I/O 模型中阻塞,高延迟等问题,尤其适用于高并发,低延迟场景。

Netty 核心组成

- EventLoop: 负责 I/O 事件的处理,是 Netty 的核心线程模型。每个 EventLoop 绑定一个线程,管理多个通道(Channel)。

- Channel: 表示网络连接的抽象,封装了底层 Socket。

- Pipeline 和 Handler: Netty 采用责任链模式,数据流通过 Pipeline 传递,每个 Handler 负责特定的逻辑处理。

- ByteBuf: Netty 提供的高效缓冲区,替代了 Java NIO 中的

ByteBuffer,提供动态扩展能力和零拷贝支持。

Netty 先进性体现

- 线程模型: 基于多路复用机制(

Selector/Epoll),实现单线程管理多连接,避免了阻塞式 I/O 的线程浪费。 - 内存管理: 通过 DirectByteBuffer 和零拷贝技术,优化数据传输,减少内存复制和分配的开销。

- 协议支持: Netty 内置多种协议支持(如 HTTP,WebSocket,TCP 等),并允许自定义协议解析。

- 易扩展性: 通过自定义

Handler,可以灵活定义业务逻辑处理。

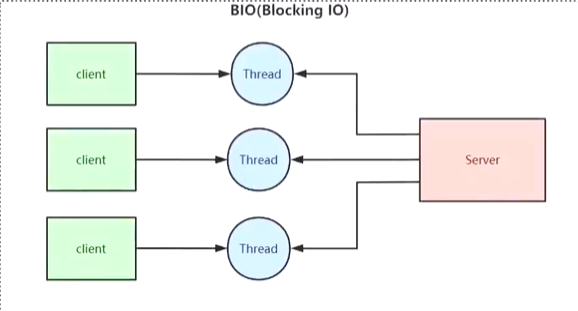

2. BIO(Blocking I/O)

工作机制

在 BIO 模型中,每个客户端连接都需要一个独立的线程进行处理。I/O 操作(如读取数据)会阻塞线程,直到操作完成。这意味着每个连接都需要消耗一个线程资源。

核心问题

- 线程资源浪费: 线程数随并发连接数线性增长,容易耗尽资源。

- 阻塞式调用: 线程在等待 I/O 数据时会阻塞,浪费 CPU 时间。

- 切换开销: 高并发下,线程频繁切换导致性能下降。

适用场景

- 小规模连接,场景简单(如低并发的文件传输服务)。

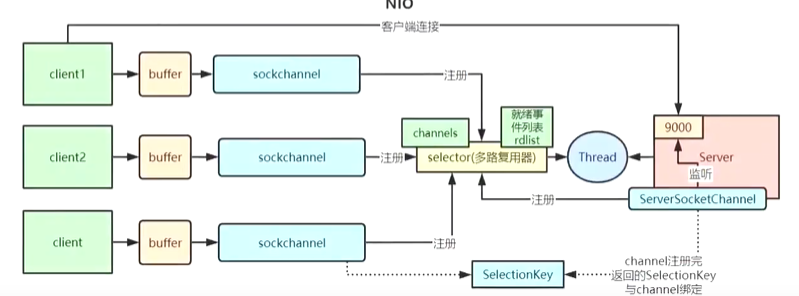

3. NIO(Non-blocking I/O)

NIO 通过引入非阻塞操作和多路复用机制解决了 BIO 的缺点。

工作机制

- Channel: 数据流的双向通道,支持非阻塞模式,配合

Selector实现 I/O 事件的管理。 - Selector: 核心组件,用于实现 I/O 多路复用,通过监听多个通道的状态,减少了线程数的使用。

- Buffer: 替代传统的流式操作,通过缓冲区管理数据读写。

技术优势

- 非阻塞性: 一个线程可以管理多个连接,I/O 操作不会阻塞线程。

- 资源节约: 大量减少线程创建和切换的开销。

- 高并发处理能力: 适合处理上万级别的并发连接。

缺点

- 编程复杂度增加:涉及异步回调和事件驱动模型。

4. Epoll

Epoll 是 Linux 提供的高效 I/O 多路复用机制。它的设计在 select 和 poll 的基础上解决了大量连接情况下的性能瓶颈。

Epoll 与传统方法对比

| 特性 | select/poll | epoll |

|---|---|---|

| 文件描述符 | 每次调用需重新传递全部描述符 | 只需注册一次,后续由内核维护 |

| 效率 | 每次都遍历所有描述符,效率低 | 仅返回活跃描述符,避免无效遍历 |

| 规模 | 支持文件描述符数有限(通常为 1024) | 支持大规模连接数,性能不随连接数增加而下降 |

| 触发模式 | 水平触发 | 支持水平触发和边缘触发 |

Epoll 的实现细节

- epoll_create: 创建一个 Epoll 实例。

- epoll_ctl: 注册,修改或删除事件。

- epoll_wait: 等待 I/O 事件的触发。

Epoll 在 Netty 中的应用

- Netty 的

EpollEventLoopGroup直接利用 Epoll 的高效事件处理机制,在 Linux 环境中比Selector更高效。

5. 零拷贝机制

零拷贝(Zero-Copy)是指在数据处理时,尽量减少内存拷贝操作,直接在不同模块之间传递数据地址,提高性能。

零拷贝技术的实现

- sendfile: 直接从文件系统发送数据到网络,避免用户空间和内核空间之间的数据拷贝。

- DirectByteBuffer: 直接使用操作系统内存,跳过 JVM 堆内存。

- FileChannel.transferTo/transferFrom: 通过底层操作系统支持直接在文件和网络之间传输数据。

Netty 中的应用

- CompositeByteBuf: 多个缓冲区逻辑组合,但物理上不进行数据拷贝。

- DirectBuffer: 直接分配内存,提升 I/O 处理效率。

6. DirectByteBuffer

DirectByteBuffer 是 Java NIO 提供的直接内存缓冲区。数据存储在操作系统内存中,跳过 JVM 堆,提升了 I/O 操作的性能。

优点

- 减少内存拷贝: 避免 JVM 和操作系统之间的数据复制。

- 提高吞吐量: 数据直接写入 Socket,适合大文件传输。

缺点

- 分配开销高: 直接内存的分配速度比堆内存慢。

- 回收难: 由操作系统管理,需手动释放,容易导致内存泄漏。

7. 长连接与心跳保活机制

长连接是在客户端与服务器之间保持一个持久的连接,用于多次通信而无需重新建立连接。

优点

- 减少连接建立的开销(如三次握手)。

- 提高实时性,适用于需要频繁通信的场景。

心跳保活机制

心跳机制通过定期发送信号包,检测连接状态,避免因空闲时间过长导致连接被关闭。

Netty 的实现

- IdleStateHandler: 检测读,写或读写空闲时间,触发心跳事件。

- 用户自定义心跳逻辑: 可以在

Handler中响应空闲事件,并发送心跳包。

8. I/O 多路复用

I/O 多路复用允许一个线程同时监视多个 I/O 通道,只有当某个通道准备好时才进行操作。

实现方式

- select: 较早的多路复用机制,每次调用需遍历全部描述符。

- poll: 改进版,使用链表存储描述符,但仍需遍历。

- epoll: 高效实现,仅返回活跃描述符,适合大规模连接。

Netty 与多路复用

Netty 通过封装 Java NIO 的 Selector 或 Linux 的 Epoll 提供 I/O 多路复用支持。

总结表:关键技术对比

| 技术 | 优点 | 缺点 |

|---|---|---|

| BIO | 简单易用,适合小规模应用 | 高并发性能差,线程资源浪费 |

| NIO | 非阻塞,支持多路复用,资源利用率高 | 编程复杂,调试困难 |

| Epoll | 高效处理大规模连接,适合高并发环境 | 仅适用于 Linux |

| 零拷贝 | 提升性能,减少内存复制 | 实现复杂,需操作系统支持 |

| DirectByteBuffer | 高效传输数据,适合大文件和高吞吐场景 | 分配开销高,需手动释放 |

| 长连接心跳保活 | 保持连接活跃,提升实时性 | 占用连接资源,需 |